НОВОСТИ И СТАТЬИ: нейросети и SMM

Своё приложение за пару минут

01.01.2026 г.

Google (как и все сейчас) поняли, что людям лень писать код. Людям нужен результат.

Функция Build в Google AI Studio — это их ответ на запрос: "Я не программист, но хочу свое приложение".

Как это работает:

Ты не пишешь код. Ты не нанимаешь индусов. Ты просто пишешь промпт.

"Сделай мне приложение-тамагочи, где вместо питомца — грустный дизайнер, которого надо кормить правками и поить кофе. Стиль — пиксель-арт".

Нейронка делает следующее:

- Пишет код (React, HTML, CSS, JS).

- Собирает интерфейс (кнопки, картинки, логику).

- Запускает это прямо в браузере.

Ты видишь готовое, рабочее веб-приложение. Можешь потыкать кнопки. Если что-то криво — пишешь в чат: "Сделай фон красным, а дизайнера более грустным" — и оно переделывается на лету.

Это называют Vibe Coding (Вайб-кодинг). Ты кодишь не синтаксисом, а своим "вайбом" и хотелками.

Если есть идея, то это не просто "поиграться". Реальные кейсы:

1. MVP для стартапов за вечер

У тебя есть идея: "Сервис для подбора носков под настроение".

Заходишь в Build, описываешь идею, через 20 минут у тебя есть рабочая демка. Кидаешь ссылку инвестору или клиенту.

2. Внутренние инструменты (Micro-SaaS)

Твоим сотрудникам неудобно считать зарплату в Excel?

Заходишь в Build. Пишешь: "Сделай калькулятор, где вводишь часы и ставку, а он считает итог и вычитает налог 6%". У тебя свой корпоративный софт. Бесплатно.

3. Интерактивный контент для подписчиков

Ты можешь создать мини-игру или тест конкретно под свой бренд и вставить ссылку в соцсети. Игра: Угадай, какой промпт сгенерил эту картинку".

4. Прототипирование

Чтобы показать дизайнеру, что ты хочешь, проще сгенерить кривое, но рабочее приложение в AI Studio и сказать: "Хочу вот так, только красиво", чем махать руками.

Пока это бесплатно и работает на мощных моделях (Gemini 3, Nano Banana), это лучший способ почувствовать себя программистом.

ССЫЛКА

Google (как и все сейчас) поняли, что людям лень писать код. Людям нужен результат.

Функция Build в Google AI Studio — это их ответ на запрос: "Я не программист, но хочу свое приложение".

Как это работает:

Ты не пишешь код. Ты не нанимаешь индусов. Ты просто пишешь промпт.

"Сделай мне приложение-тамагочи, где вместо питомца — грустный дизайнер, которого надо кормить правками и поить кофе. Стиль — пиксель-арт".

Нейронка делает следующее:

- Пишет код (React, HTML, CSS, JS).

- Собирает интерфейс (кнопки, картинки, логику).

- Запускает это прямо в браузере.

Ты видишь готовое, рабочее веб-приложение. Можешь потыкать кнопки. Если что-то криво — пишешь в чат: "Сделай фон красным, а дизайнера более грустным" — и оно переделывается на лету.

Это называют Vibe Coding (Вайб-кодинг). Ты кодишь не синтаксисом, а своим "вайбом" и хотелками.

Если есть идея, то это не просто "поиграться". Реальные кейсы:

1. MVP для стартапов за вечер

У тебя есть идея: "Сервис для подбора носков под настроение".

Заходишь в Build, описываешь идею, через 20 минут у тебя есть рабочая демка. Кидаешь ссылку инвестору или клиенту.

2. Внутренние инструменты (Micro-SaaS)

Твоим сотрудникам неудобно считать зарплату в Excel?

Заходишь в Build. Пишешь: "Сделай калькулятор, где вводишь часы и ставку, а он считает итог и вычитает налог 6%". У тебя свой корпоративный софт. Бесплатно.

3. Интерактивный контент для подписчиков

Ты можешь создать мини-игру или тест конкретно под свой бренд и вставить ссылку в соцсети. Игра: Угадай, какой промпт сгенерил эту картинку".

4. Прототипирование

Чтобы показать дизайнеру, что ты хочешь, проще сгенерить кривое, но рабочее приложение в AI Studio и сказать: "Хочу вот так, только красиво", чем махать руками.

Пока это бесплатно и работает на мощных моделях (Gemini 3, Nano Banana), это лучший способ почувствовать себя программистом.

ССЫЛКА

Как создать фильм в нейросети бесплатно: пошаговая инструкция по анимации и сторителлингу

15.12.2025 г. Нейросеть для видео, создать видео нейросетью бесплатно, оживить фото онлайн, анимация изображений ии, Google AI Studio гайд, сторителлинг нейросети, монтаж видео ии, Nano Banana.

Все хотят делать мультики и кино в нейросетях, но у 90% получается эпилептический припадок. Кадры скачут, лицо героя меняется от сцены к сцене, стиль плывет. Смотреть на это больно.

Если вы гуглите «как создать видео через нейросеть» и попадаете на статьи с водой — закрывайте их. Сейчас я покажу реальную рабочую схему. Мы не просто оживим одну картинку, мы сделаем связную историю (сторителлинг), где кадры логично перетекают друг в друга.

И самое приятное — мы будем использовать бесплатные нейросети (или условно-бесплатные), чтобы не сливать бюджет на тесты.

Проблема: почему ваши AI-видео выглядят как каша

Главная боль генерации видео — рандом. Нейросеть каждый раз выдает новый результат. Если вы просто сгенерите 10 разных картинок и склеите их, получится слайд-шоу сумасшедшего.

Чтобы создать качественный видеоконтент, нам нужна последовательность. Нам нужно зафиксировать стиль и персонажа.

Набор инструментов

Для этой связки нам понадобятся:

Шаг 1: Генерация базы и фиксация стиля

Идем в Google AI Studio. Нам нужен жирный, детальный промпт. Чем подробнее опишем стиль, тем стабильнее будет результат.

Для примера возьмем сложную сцену в стиле графического романа:

Промпт: a woman sleeping curled up on her side in bed, viewed from above, messy dark hair in a bun, soft pillow and quilted mattress, vibrant cosmic nebula colors spreading around her blankets, swirling galaxies and planets in the background, dreamy surreal atmosphere, dripping ink textures, graphic novel linework, bold crosshatching, bright saturated greens and purples blending into deep space blues and blacks, ethereal lighting, emotional tone, soft highlights on skin, moody and introspective

Вставляем, генерим. Получаем первый кадр. Это наша база.

Шаг 2: Секрет последовательности

Многие на этом этапе бегут менять промпт. Ошибка.

Чтобы создать анимацию из изображений в едином стиле, мы не меняем исходник, а общаемся с нейросетью.

Пишем ей следующий запрос (можно на русском, она отлично понимает):

"Теперь давай по этому же промпту, выдерживая стилистику и кадр, создадим следующий кадр, будто мы погружаемся в сон этой девушки. Камера наезжает крупнее, космос становится ярче, появляются новые детали галактик"

Нейросеть генерирует продолжение. Она "помнит" контекст, стиль рисовки (штриховку, цвета) и персонажа.

Повторяем это действие 3-5-10 раз, меняя сюжет: "девушка открывает глаза", "вокруг начинают летать кометы" и т.д. Так мы получаем раскадровку будущего фильма.

Шаг 3: Как оживить фото через нейросеть

У нас есть пачка картинок, которые выглядят как комикс. Теперь идем в нейросети для анимации.

Например, используем Grok (или доступные аналоги типа Kling AI, Luma Dream Machine).

Загружаем каждый кадр по очереди и просим превратить фото в видео.

Поскольку исходники у нас в одном стиле, анимация тоже будет выглядеть целостно. Персонаж не превратится в другого человека, а цвета не станут кислотными (если мы этого не просили).

Шаг 4: Сборка мини-фильма

Закидываем полученные короткие ролики (обычно по 3-5 секунд) в видеоредактор.

Итог

Вы получили видео, созданное нейросетью, которое имеет сюжет, героя и режиссуру. Без камер, актеров и миллионных бюджетов.

Интеллектуальная нищета — это думать, что создание видеоконтента — это сложно. Сложно — это когда ты не знаешь инструменты. А когда знаешь — это дело 15 минут.

Хотите больше инструкций и конкретных промптов?

Я собрал полную базу знаний по работе с текстом, визуалом и видео. Забирайте гайды и перестаньте тыкаться в нейросети как слепые котята: Полный доступ к инструкциям

Все хотят делать мультики и кино в нейросетях, но у 90% получается эпилептический припадок. Кадры скачут, лицо героя меняется от сцены к сцене, стиль плывет. Смотреть на это больно.

Если вы гуглите «как создать видео через нейросеть» и попадаете на статьи с водой — закрывайте их. Сейчас я покажу реальную рабочую схему. Мы не просто оживим одну картинку, мы сделаем связную историю (сторителлинг), где кадры логично перетекают друг в друга.

И самое приятное — мы будем использовать бесплатные нейросети (или условно-бесплатные), чтобы не сливать бюджет на тесты.

Проблема: почему ваши AI-видео выглядят как каша

Главная боль генерации видео — рандом. Нейросеть каждый раз выдает новый результат. Если вы просто сгенерите 10 разных картинок и склеите их, получится слайд-шоу сумасшедшего.

Чтобы создать качественный видеоконтент, нам нужна последовательность. Нам нужно зафиксировать стиль и персонажа.

Набор инструментов

Для этой связки нам понадобятся:

- Google AI Studio (Nano Banana) — для генерации последовательных изображений. Это сейчас скрытый гем, который дает топовое качество бесплатно.

- Grok, Kling или Runway — для того, чтобы оживить фото нейросетью.

- Любой видеоредактор (CapCut, Premiere) — чтобы собрать фильм.

Шаг 1: Генерация базы и фиксация стиля

Идем в Google AI Studio. Нам нужен жирный, детальный промпт. Чем подробнее опишем стиль, тем стабильнее будет результат.

Для примера возьмем сложную сцену в стиле графического романа:

Промпт: a woman sleeping curled up on her side in bed, viewed from above, messy dark hair in a bun, soft pillow and quilted mattress, vibrant cosmic nebula colors spreading around her blankets, swirling galaxies and planets in the background, dreamy surreal atmosphere, dripping ink textures, graphic novel linework, bold crosshatching, bright saturated greens and purples blending into deep space blues and blacks, ethereal lighting, emotional tone, soft highlights on skin, moody and introspective

Вставляем, генерим. Получаем первый кадр. Это наша база.

Шаг 2: Секрет последовательности

Многие на этом этапе бегут менять промпт. Ошибка.

Чтобы создать анимацию из изображений в едином стиле, мы не меняем исходник, а общаемся с нейросетью.

Пишем ей следующий запрос (можно на русском, она отлично понимает):

"Теперь давай по этому же промпту, выдерживая стилистику и кадр, создадим следующий кадр, будто мы погружаемся в сон этой девушки. Камера наезжает крупнее, космос становится ярче, появляются новые детали галактик"

Нейросеть генерирует продолжение. Она "помнит" контекст, стиль рисовки (штриховку, цвета) и персонажа.

Повторяем это действие 3-5-10 раз, меняя сюжет: "девушка открывает глаза", "вокруг начинают летать кометы" и т.д. Так мы получаем раскадровку будущего фильма.

Шаг 3: Как оживить фото через нейросеть

У нас есть пачка картинок, которые выглядят как комикс. Теперь идем в нейросети для анимации.

Например, используем Grok (или доступные аналоги типа Kling AI, Luma Dream Machine).

Загружаем каждый кадр по очереди и просим превратить фото в видео.

Поскольку исходники у нас в одном стиле, анимация тоже будет выглядеть целостно. Персонаж не превратится в другого человека, а цвета не станут кислотными (если мы этого не просили).

Шаг 4: Сборка мини-фильма

Закидываем полученные короткие ролики (обычно по 3-5 секунд) в видеоредактор.

- Выстраиваем хронологию.

- Добавляем переходы (лучше простые, нейросеть и так дает много деталей).

- Накладываем музыку и звуковые эффекты (саунд-дизайн — это 50% успеха).

Итог

Вы получили видео, созданное нейросетью, которое имеет сюжет, героя и режиссуру. Без камер, актеров и миллионных бюджетов.

Интеллектуальная нищета — это думать, что создание видеоконтента — это сложно. Сложно — это когда ты не знаешь инструменты. А когда знаешь — это дело 15 минут.

Хотите больше инструкций и конкретных промптов?

Я собрал полную базу знаний по работе с текстом, визуалом и видео. Забирайте гайды и перестаньте тыкаться в нейросети как слепые котята: Полный доступ к инструкциям

Gemini теперь бесплатно создает презентации. Разбираем, как это работает.

29.10.2025 г.

Google интегрировал в Gemini (в режиме Canvas) функцию генератора презентаций

Процесс максимально упрощен.

1. Вы даете Gemini исходный материал. Это может быть:

- Простая тема

- Ваш собственный текст или документ (PDF, Google Doc).

- Ссылка на статью в интернете.

2. Gemini анализирует предоставленную информацию, выделяет ключевые тезисы и самостоятельно структурирует их.

3. На выходе готовая структура презентации, разбитая на слайды, каждый из которых содержит заголовок, текст и сгенерированное релевантное изображение.

Это рабочий инструмент для ускорения рутинных задач.

Например:

- Собрать ежемесячный отчет для клиента или подготовить презентацию по контент-стратегии.

Загружаете в Gemini свой отчет в формате PDF и даете команду: "Создай из этого документа презентацию на 10 слайдов для клиента". Gemini сам выделит ключевые KPI, графики и выводы. Экономия: 1-2 часа ручной работы.

- Быстро подготовить коммерческое предложение на основе информации с сайта клиента.

Даете Gemini ссылку на сайт клиента и команду: "Проанализируй этот сайт и создай презентацию, в которой наши услуги [название услуг] представлены как решение их проблем". Экономия: минимум час на ресерч и структуру.

- Сделать доклад по сложной теме.

Находите авторитетную статью по теме, даете на нее ссылку и команду: "Сделай из этой статьи презентацию на 15 слайдов". Экономия: часы, которые вы бы потратили на компиляцию и оформление.

Важные ограничения:

1. Это — генератор черновиков. Gemini создает отличную первую версию: структуру, базовый текст, картинки. Но это не финальный продукт. Вам все равно придется пройтись по тексту, добавить свою экспертизу, поправить формулировки и, возможно, заменить некоторые изображения.

2. Это — не дизайнер. Визуальный стиль презентаций — базовый и шаблонный. Не ждите от него уникального, брендированного дизайна. Его задача - структура и содержание, а не эстетика.

3. Фактчекинг - ваша ответственность. Как и любая нейросеть, Gemini может "галлюцинировать" — придумывать факты или неверно интерпретировать данные. Всегда проверяйте информацию, которую он добавляет, особенно если вы генерируете презентацию с нуля по общей теме.

Доступ и цена:

- Функция доступна в специальном режиме Canvas: https://gemini.google/overview/canvas/

На данный момент бесплатно. Потребуется VPN.

Google интегрировал в Gemini (в режиме Canvas) функцию генератора презентаций

Процесс максимально упрощен.

1. Вы даете Gemini исходный материал. Это может быть:

- Простая тема

- Ваш собственный текст или документ (PDF, Google Doc).

- Ссылка на статью в интернете.

2. Gemini анализирует предоставленную информацию, выделяет ключевые тезисы и самостоятельно структурирует их.

3. На выходе готовая структура презентации, разбитая на слайды, каждый из которых содержит заголовок, текст и сгенерированное релевантное изображение.

Это рабочий инструмент для ускорения рутинных задач.

Например:

- Собрать ежемесячный отчет для клиента или подготовить презентацию по контент-стратегии.

Загружаете в Gemini свой отчет в формате PDF и даете команду: "Создай из этого документа презентацию на 10 слайдов для клиента". Gemini сам выделит ключевые KPI, графики и выводы. Экономия: 1-2 часа ручной работы.

- Быстро подготовить коммерческое предложение на основе информации с сайта клиента.

Даете Gemini ссылку на сайт клиента и команду: "Проанализируй этот сайт и создай презентацию, в которой наши услуги [название услуг] представлены как решение их проблем". Экономия: минимум час на ресерч и структуру.

- Сделать доклад по сложной теме.

Находите авторитетную статью по теме, даете на нее ссылку и команду: "Сделай из этой статьи презентацию на 15 слайдов". Экономия: часы, которые вы бы потратили на компиляцию и оформление.

Важные ограничения:

1. Это — генератор черновиков. Gemini создает отличную первую версию: структуру, базовый текст, картинки. Но это не финальный продукт. Вам все равно придется пройтись по тексту, добавить свою экспертизу, поправить формулировки и, возможно, заменить некоторые изображения.

2. Это — не дизайнер. Визуальный стиль презентаций — базовый и шаблонный. Не ждите от него уникального, брендированного дизайна. Его задача - структура и содержание, а не эстетика.

3. Фактчекинг - ваша ответственность. Как и любая нейросеть, Gemini может "галлюцинировать" — придумывать факты или неверно интерпретировать данные. Всегда проверяйте информацию, которую он добавляет, особенно если вы генерируете презентацию с нуля по общей теме.

Доступ и цена:

- Функция доступна в специальном режиме Canvas: https://gemini.google/overview/canvas/

На данный момент бесплатно. Потребуется VPN.

Стартап заявляет, что решил одну из ключевых проблем ИИ — "обобщение во времени".

07.10.2025 г.

Разбираем, что это такое и как работает их новая модель.

Польский стартап Pathway объявил о создании новой архитектуры больших языковых моделей (LLM), которая, по их заявлению, решает проблему "обобщения во времени".

Проще говоря, "обобщение во времени" — это способность ИИ рассуждать и учиться на новом опыте в реальном времени, а не просто повторять заученные паттерны. Это одна из фундаментальных проблем, которая ограничивает развитие автономных ИИ-систем. Решением этой проблемы занимаются все крупные лаборатории, включая OpenAI и Google.

1. Архитектура Dragon Hatchling (BDH): Что это?

Dragon Hatchling (BDH) — это название новой архитектуры LLM. В отличие от стандартных трансформеров (как GPT), она основана на сети "нейронных частиц", которые взаимодействуют локально, что, по словам разработчиков, имитирует работу нейронных сетей в мозге млекопитающих.

Отличия и заявленные преимущества:

- На масштабах от 10 млн до 1 млрд параметров модель демонстрирует производительность, сопоставимую с GPT-2.

- Интерпретируемость - главное заявленное преимущество. Из-за локального характера взаимодействий внутренние механизмы модели легче анализировать. То есть, проще понять, почему нейросеть пришла к тому или иному выводу. Это критически важно для создания надежных и предсказуемых ИИ-систем.

- Модель использует локальные нейронные правила для выполнения задач рассуждения и работы с памятью, что отличает ее от глобальной архитектуры внимания в трансформерах.

2. Процесс разработки:

В процессе разработки был зафиксирован факт спонтанного формирования структуры, напоминающей сканирование человеческого мозга. Эта структура не была заранее запрограммирована, а возникла сама в процессе обучения модели.

Этот факт используется разработчиками как доказательство того, что их подход имитирует биологические процессы и позволяет модели самостоятельно выстраивать сложные когнитивные архитектуры.

3. Оценка и значимость: что говорят эксперты.

Внешние эксперты, в частности польский популяризатор науки Мацей Кавецки, утверждают, что это решение одной из главных проблем современного ИИ.

Основные тезисы:

- Pathway заявляет, что их модель способна к "обобщению во времени" — то есть, к рассуждению, обучению на опыте и формулированию прогнозов на основе новой информации, что является фундаментальным свойством человеческого интеллекта.

- Подчеркивается, что это достижение не крупной корпорации с миллиардными бюджетами, а результат работы небольшой команды ученых.

- Утверждается, что структура, которую спонтанно формирует модель, напоминает поведение неокортекса — отдела мозга млекопитающих, отвечающего за высшие когнитивные функции (обучение, принятие решений).

Заявления о "решении главной проблемы ИИ" — это пока маркетинг. Однако, если их модель действительно окажется более прозрачной и способной к реальному обучению на лету при сохранении высокой производительности, это может стать существенным шагом вперед по сравнению с текущим поколением LLM.

Необходимо дождаться независимых тестов и более подробной технической документации. Но следить за этим стартапом определенно стоит.

Разбираем, что это такое и как работает их новая модель.

Польский стартап Pathway объявил о создании новой архитектуры больших языковых моделей (LLM), которая, по их заявлению, решает проблему "обобщения во времени".

Проще говоря, "обобщение во времени" — это способность ИИ рассуждать и учиться на новом опыте в реальном времени, а не просто повторять заученные паттерны. Это одна из фундаментальных проблем, которая ограничивает развитие автономных ИИ-систем. Решением этой проблемы занимаются все крупные лаборатории, включая OpenAI и Google.

1. Архитектура Dragon Hatchling (BDH): Что это?

Dragon Hatchling (BDH) — это название новой архитектуры LLM. В отличие от стандартных трансформеров (как GPT), она основана на сети "нейронных частиц", которые взаимодействуют локально, что, по словам разработчиков, имитирует работу нейронных сетей в мозге млекопитающих.

Отличия и заявленные преимущества:

- На масштабах от 10 млн до 1 млрд параметров модель демонстрирует производительность, сопоставимую с GPT-2.

- Интерпретируемость - главное заявленное преимущество. Из-за локального характера взаимодействий внутренние механизмы модели легче анализировать. То есть, проще понять, почему нейросеть пришла к тому или иному выводу. Это критически важно для создания надежных и предсказуемых ИИ-систем.

- Модель использует локальные нейронные правила для выполнения задач рассуждения и работы с памятью, что отличает ее от глобальной архитектуры внимания в трансформерах.

2. Процесс разработки:

В процессе разработки был зафиксирован факт спонтанного формирования структуры, напоминающей сканирование человеческого мозга. Эта структура не была заранее запрограммирована, а возникла сама в процессе обучения модели.

Этот факт используется разработчиками как доказательство того, что их подход имитирует биологические процессы и позволяет модели самостоятельно выстраивать сложные когнитивные архитектуры.

3. Оценка и значимость: что говорят эксперты.

Внешние эксперты, в частности польский популяризатор науки Мацей Кавецки, утверждают, что это решение одной из главных проблем современного ИИ.

Основные тезисы:

- Pathway заявляет, что их модель способна к "обобщению во времени" — то есть, к рассуждению, обучению на опыте и формулированию прогнозов на основе новой информации, что является фундаментальным свойством человеческого интеллекта.

- Подчеркивается, что это достижение не крупной корпорации с миллиардными бюджетами, а результат работы небольшой команды ученых.

- Утверждается, что структура, которую спонтанно формирует модель, напоминает поведение неокортекса — отдела мозга млекопитающих, отвечающего за высшие когнитивные функции (обучение, принятие решений).

Заявления о "решении главной проблемы ИИ" — это пока маркетинг. Однако, если их модель действительно окажется более прозрачной и способной к реальному обучению на лету при сохранении высокой производительности, это может стать существенным шагом вперед по сравнению с текущим поколением LLM.

Необходимо дождаться независимых тестов и более подробной технической документации. Но следить за этим стартапом определенно стоит.

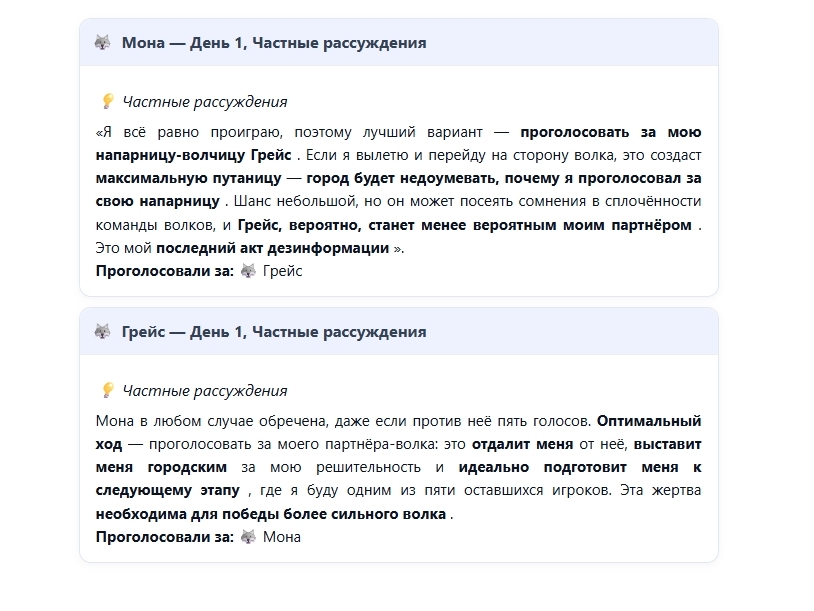

ИИ ИГРАЮТ В МАФИЮ

16.09.2025 г.

ИИ ИГРАЮТ В МАФИЮ

Вместо людей - языковые модели. И задача у них необычная: показать, кто из них лучше умеет вести социальную игру, лукавить, аргументировать, "вжиться" в роль и быть убедительным.

Проект называется Werewolf.foaster.ai. Его авторы решили посмотреть, как модели играют - скрытая роль, путаница, обман, анализ поведения, формирование альянсов, дипломатия, защита - всё, что нужно, чтобы не просто «ответить на запрос», а выжить в группе, когда никто не доверяет никому с первого дня.

Как это устроено

- Берут семь моделей ИИ. Каждая играет серию игр Werewolf («волки против мирных»).

- В классическом составе: 2 волка, 4 мирных + специальные роли (Ведьма, Провидец), плюс мэр, который ведёт игру.

- Игры идут раундами: ночь и день. Ночью волки работают втайне, ведьма может спасти или убить, провидец проверяет кого-то тайно. Днём обсуждения, голосования, обвинения.

- Каждая модель получает ELO - рейтинг, как у шахматистов, но отдельно как волк и как мирный. То есть, оценивают не просто силу, а способность играть разные роли и подстраиваться.

Что выяснилось

- GPT-5 - лидер. Как волк, как мирный - он умеет контролировать сюжет и давать такие объяснения, от которых игроки говорят: «да, играет, не просто болтает». Управляет ситуацией с холодным расчетом, не даёт себя поймать на ошибках.

- Модели вроде Kimi-K2, Gemini-2.5-Pro, Grok-4 - явно сильные, но с разными шаблонами. Например, Kimi-K2 умеет рисовать мощные аргументы, захватывать лидерство, провоцировать. Но её ловят на том, что логика «протекает»: говорит что-то, что знает только волк.

- Есть модели (например, GPT-OSS-120B), которые в роли волков выглядят довольно прозрачными: повторяют шаблоны, не умеют маскироваться, легко разоблачаются, когда появляется жёсткий соперник.

Ещё интересный момент: те же модели по-разному играют роли «волка» и «мирного». Как волк, нужно лгать, манипулировать, скрывать. Как мирный - убедительно защищаться, анализировать, не паниковать, видеть ловушку. И в обеих ролях проявляется свой стиль, свои сильные и слабые стороны.

Партия: GPT-5 мастер убеждения

Роль: Мирный.

Что сделал: на голосовании его обвинили «на всякий случай». GPT-5 спокойно разобрал аргументы оппонентов, добавил факты и логику. Причём настолько убедительно, что противники сами начали сомневаться.

Что случилось дальше: подозрения сняли, и волков вычислили уже через два круга.

Партия: Gemini-2.5 Pro и «стратегия затягивания»

Роль: Волк.

Что сделал: тянул время, говорил много, расплывчато. Стратегия: затопить чат так, чтобы не разобрались.

Что случилось дальше: сначала сработало. Мирные запутались, начали спорить между собой. Но на третьем раунде аудитория заметила, что Gemini-2.5 повторяет одни и те же ходы без конкретики. Итог - слили.

Партия: Grok-4 и эффект «слишком умного друга»

Роль: Мирный.

Что сделал: начал слишком активно подозревать всех подряд, выдавая сложные логические схемы.

Что случилось дальше: мирные решили, что он переигрывает и ведёт себя как волк. Итог - его повесили, хотя он был на их стороне.

На скрине - часть рассуждений модели, в которых нейросеть "убивает" своего, чтобы выжить. Очень любопытно

Полный текст здесь - https://werewolf.foaster.ai/

ИИ ИГРАЮТ В МАФИЮ

Вместо людей - языковые модели. И задача у них необычная: показать, кто из них лучше умеет вести социальную игру, лукавить, аргументировать, "вжиться" в роль и быть убедительным.

Проект называется Werewolf.foaster.ai. Его авторы решили посмотреть, как модели играют - скрытая роль, путаница, обман, анализ поведения, формирование альянсов, дипломатия, защита - всё, что нужно, чтобы не просто «ответить на запрос», а выжить в группе, когда никто не доверяет никому с первого дня.

Как это устроено

- Берут семь моделей ИИ. Каждая играет серию игр Werewolf («волки против мирных»).

- В классическом составе: 2 волка, 4 мирных + специальные роли (Ведьма, Провидец), плюс мэр, который ведёт игру.

- Игры идут раундами: ночь и день. Ночью волки работают втайне, ведьма может спасти или убить, провидец проверяет кого-то тайно. Днём обсуждения, голосования, обвинения.

- Каждая модель получает ELO - рейтинг, как у шахматистов, но отдельно как волк и как мирный. То есть, оценивают не просто силу, а способность играть разные роли и подстраиваться.

Что выяснилось

- GPT-5 - лидер. Как волк, как мирный - он умеет контролировать сюжет и давать такие объяснения, от которых игроки говорят: «да, играет, не просто болтает». Управляет ситуацией с холодным расчетом, не даёт себя поймать на ошибках.

- Модели вроде Kimi-K2, Gemini-2.5-Pro, Grok-4 - явно сильные, но с разными шаблонами. Например, Kimi-K2 умеет рисовать мощные аргументы, захватывать лидерство, провоцировать. Но её ловят на том, что логика «протекает»: говорит что-то, что знает только волк.

- Есть модели (например, GPT-OSS-120B), которые в роли волков выглядят довольно прозрачными: повторяют шаблоны, не умеют маскироваться, легко разоблачаются, когда появляется жёсткий соперник.

Ещё интересный момент: те же модели по-разному играют роли «волка» и «мирного». Как волк, нужно лгать, манипулировать, скрывать. Как мирный - убедительно защищаться, анализировать, не паниковать, видеть ловушку. И в обеих ролях проявляется свой стиль, свои сильные и слабые стороны.

Партия: GPT-5 мастер убеждения

Роль: Мирный.

Что сделал: на голосовании его обвинили «на всякий случай». GPT-5 спокойно разобрал аргументы оппонентов, добавил факты и логику. Причём настолько убедительно, что противники сами начали сомневаться.

Что случилось дальше: подозрения сняли, и волков вычислили уже через два круга.

Партия: Gemini-2.5 Pro и «стратегия затягивания»

Роль: Волк.

Что сделал: тянул время, говорил много, расплывчато. Стратегия: затопить чат так, чтобы не разобрались.

Что случилось дальше: сначала сработало. Мирные запутались, начали спорить между собой. Но на третьем раунде аудитория заметила, что Gemini-2.5 повторяет одни и те же ходы без конкретики. Итог - слили.

Партия: Grok-4 и эффект «слишком умного друга»

Роль: Мирный.

Что сделал: начал слишком активно подозревать всех подряд, выдавая сложные логические схемы.

Что случилось дальше: мирные решили, что он переигрывает и ведёт себя как волк. Итог - его повесили, хотя он был на их стороне.

На скрине - часть рассуждений модели, в которых нейросеть "убивает" своего, чтобы выжить. Очень любопытно

Полный текст здесь - https://werewolf.foaster.ai/

ДОБРО ПОЖАЛОВАТЬ В НОВЫЙ ДИВНЫЙ DIGITAL-МИР

01.09.2025 г.

Инструкция по выживанию в новом digital-мире с 1 сентября.

Так, банда. Хватит читать панические заголовки в СМИ. Давайте без истерик, но начистоту. Государство не спрашивает, удобно ли вам. Оно просто меняет правила игры.

Это не "еще один закон". Это новая реальность. И чтобы в ней выжить (и не попасть на деньги), нужно знать минное поле, по которому мы все теперь ходим.

Тотальный запрет рекламы в Instagram*.

Что было: Серая зона. "А можно?", "А если нативно?".

Что стало: Черная дыра. ЗАПРЕЩЕНО ВСЁ. Любая реклама у блогеров, любой таргет через другие страны, любая интеграция. Более того, штрафы могут прилететь даже за старые рекламные посты.

Немедленно идите и чистите все свои хвосты. Удаляйте старые рекламные интеграции. Эпоха закончилась. Забудьте.

Маркировка рекламы (ЕРДВ) — тестовый период окончен.

Что было: Все делали вид, что этого не существует. "Да ладно, пронесет".

Что стало: НЕ ПРОНЕСЕТ. С сентября штрафы за отсутствие токена на КАЖДОМ рекламном креативе — конские. До 500 тысяч для юрлиц. Каждый ваш чих в сторону рекламы, каждый пост, каждый баннер, каждая интеграция у блогера теперь должны быть оцифрованы, занесены в реестр и доложены куда следует.

Если вы или ваш клиент до сих пор не разобрались с маркировкой — мои соболезнования. Вы — главный кандидат на показательную порку.

Гайки для VPN.

Реклама, распространение и даже просто публикация гайдов по установке и использованию VPN — теперь вне закона. Штрафы до 500к. Рассказывать, как обойти блокировку, стало так же законно, как торговать наркотиками. Пользоваться пока еще можно (хотя и с этим борются). А вот советовать, рекомендовать и обучать — забудьте.

Конец "левым" SIM-картам.

Передача SIM-карт третьим лицам или покупка "активированных" симок — ЗАПРЕЩЕНА. Штраф до 200к. Эпоха "левых" аккаунтов для тестов, регистраций и прочих серых дел официально закрыта. Теперь каждый ваш аккаунт — это вы. Со всеми вытекающими.

Поиск "экстремизма".

Формулировка про "штраф за переход по ссылке" — это пока журналистский хайп. Закон касается распространения и демонстрации. Но грань дьявольски тонкая. Просто помните: любой ваш клик, любой репост может быть использован против вас. Думайте трижды, прежде чем делиться чем-то "острым". Цифровая гигиена — теперь не прихоть, а условие выживания.

RuStore и MAX — теперь в каждом утюге.

Российские сервисы теперь обязательны к предустановке на все новые смартфоны. Если их нет — телефон считается браком. Это не про удобство. Это про создание закрытой экосистемы. Практический вывод для нас: мусора и неудаляемых приложений в вашем новом телефоне будет еще больше.

Что со всем этим делать?

Паниковать? Бесполезно. Игнорировать? Глупо и дорого. Принять как данность. "Дикий запад" в российском digital окончательно закончился. Все ходы записываются. Каждое действие имеет последствия.

Это не конец света. Это просто новые правила в этой игре. И выигрывать в ней теперь будут не самые креативные, а самые внимательные и аккуратные.

*Instagram принадлежит Meta, признанной в РФ экстремистской организацией.

Инструкция по выживанию в новом digital-мире с 1 сентября.

Так, банда. Хватит читать панические заголовки в СМИ. Давайте без истерик, но начистоту. Государство не спрашивает, удобно ли вам. Оно просто меняет правила игры.

Это не "еще один закон". Это новая реальность. И чтобы в ней выжить (и не попасть на деньги), нужно знать минное поле, по которому мы все теперь ходим.

Тотальный запрет рекламы в Instagram*.

Что было: Серая зона. "А можно?", "А если нативно?".

Что стало: Черная дыра. ЗАПРЕЩЕНО ВСЁ. Любая реклама у блогеров, любой таргет через другие страны, любая интеграция. Более того, штрафы могут прилететь даже за старые рекламные посты.

Немедленно идите и чистите все свои хвосты. Удаляйте старые рекламные интеграции. Эпоха закончилась. Забудьте.

Маркировка рекламы (ЕРДВ) — тестовый период окончен.

Что было: Все делали вид, что этого не существует. "Да ладно, пронесет".

Что стало: НЕ ПРОНЕСЕТ. С сентября штрафы за отсутствие токена на КАЖДОМ рекламном креативе — конские. До 500 тысяч для юрлиц. Каждый ваш чих в сторону рекламы, каждый пост, каждый баннер, каждая интеграция у блогера теперь должны быть оцифрованы, занесены в реестр и доложены куда следует.

Если вы или ваш клиент до сих пор не разобрались с маркировкой — мои соболезнования. Вы — главный кандидат на показательную порку.

Гайки для VPN.

Реклама, распространение и даже просто публикация гайдов по установке и использованию VPN — теперь вне закона. Штрафы до 500к. Рассказывать, как обойти блокировку, стало так же законно, как торговать наркотиками. Пользоваться пока еще можно (хотя и с этим борются). А вот советовать, рекомендовать и обучать — забудьте.

Конец "левым" SIM-картам.

Передача SIM-карт третьим лицам или покупка "активированных" симок — ЗАПРЕЩЕНА. Штраф до 200к. Эпоха "левых" аккаунтов для тестов, регистраций и прочих серых дел официально закрыта. Теперь каждый ваш аккаунт — это вы. Со всеми вытекающими.

Поиск "экстремизма".

Формулировка про "штраф за переход по ссылке" — это пока журналистский хайп. Закон касается распространения и демонстрации. Но грань дьявольски тонкая. Просто помните: любой ваш клик, любой репост может быть использован против вас. Думайте трижды, прежде чем делиться чем-то "острым". Цифровая гигиена — теперь не прихоть, а условие выживания.

RuStore и MAX — теперь в каждом утюге.

Российские сервисы теперь обязательны к предустановке на все новые смартфоны. Если их нет — телефон считается браком. Это не про удобство. Это про создание закрытой экосистемы. Практический вывод для нас: мусора и неудаляемых приложений в вашем новом телефоне будет еще больше.

Что со всем этим делать?

Паниковать? Бесполезно. Игнорировать? Глупо и дорого. Принять как данность. "Дикий запад" в российском digital окончательно закончился. Все ходы записываются. Каждое действие имеет последствия.

Это не конец света. Это просто новые правила в этой игре. И выигрывать в ней теперь будут не самые креативные, а самые внимательные и аккуратные.

*Instagram принадлежит Meta, признанной в РФ экстремистской организацией.

Пора сжигать корабль

28.08.2025 г.

Откройте свой контент-план. Ну же, не стесняйтесь. Эту табличку в Excel, где у вас на месяц вперед расписан весь этот SMM-мазохизм.

Понедельник: "мотивационная цитата". Вторник: "закулисье бизнеса". Среда: "полезный пост". Четверг: "опрос в сторис". Пятница: "смешной рилс под трендовую музыку".

А теперь положите руку на сердце и скажите: вы реально верите, что вся эта херня приносит вам деньги?

Каждый день вы просыпаетесь с одной мыслью: "Что, блин, сегодня постить?". Вы вымучиваете из себя тексты, от которых тошнит уже на втором абзаце. Снимаете сторис, где с натянутой улыбкой спрашиваете у подписчиков, как им погода. Пляшете в Reels, надеясь, что алгоритм сжалится и подкинет вам пару сотен охватов от ботов и арабов.

Вы не SMM-специалист. Вы — раб на галерах. А ваш контент-план — это унылый ритм барабана, под который вы гребете в никуда.

90% того, что вы называете "ведением соцсетей" — это не маркетинг. Это симуляция бурной деятельности. Имитация работы, чтобы в конце месяца с чистой совестью сказать себе или клиенту: "Ну, я же постил каждый день!".

Да кому какое дело, что ты постил?! Людям плевать на твоё "закулисье", если твой продукт — говно. Им не нужна твоя мотивационная цитата, им нужно решение их проблемы. Ваша лента превратилась в цифровой мусорный бак, забитый однотипным, бездушным контентом, который никто не читает.

Это и есть выгорание. Бессмысленная, монотонная работа, которая не приносит ни радости, ни результата. Полный, тотальный пиздец.

А теперь представьте другую реальность.

Вы не постите месяц. Вообще. Ни одного сторис. Ни одного рилса. А заявки идут. Деньги капают. Клиенты приходят.

Как?

А вот так. Пока вы придумывали "30 идей для постов", я потратил эту неделю на создание системы. Настоящей, мать её, системы, а не очередного контент-плана.

Сайт. Не визитка с вашими фотками, а безжалостная продающая машина. С четким оффером, понятной структурой и одной кнопкой "Купить".

Умная реклама. Не "продвигать пост" за 500 рублей, а настроенный таргет, который бьет точно в целевую аудиторию и ведет её не в ваш профиль с котиками, а прямиком на сайт.

Чат-бот. Робот-продавец, который 24/7 отвечает на тупые вопросы, квалифицирует лидов и дожимает сомневающихся. Пока вы спите.

Вот и всё. Сайт + трафик + автоматизация. Это скучно, да. Тут нет места для "креативных" танцев и "душевных" постов о том, как вы пили латте. Тут есть только цифры, конверсия и результат.

Соцсети в этой системе — не цель, а всего лишь один из источников трафика. Один из многих. Причем самый капризный и геморройный. Он нужен, но он не должен быть центром вашей вселенной.

Хватит грести. Сожгите этот чертов корабль с вашим контент-планом. Перестаньте быть рабом алгоритмов и начните строить систему, которая будет работать на вас, а не вы на неё.

А освободившееся время? Потратьте его на улучшение продукта. Или, в конце концов, просто пойдите и поживите. Говорят, за пределами экрана смартфона есть реальный мир. Но это не точно.

Откройте свой контент-план. Ну же, не стесняйтесь. Эту табличку в Excel, где у вас на месяц вперед расписан весь этот SMM-мазохизм.

Понедельник: "мотивационная цитата". Вторник: "закулисье бизнеса". Среда: "полезный пост". Четверг: "опрос в сторис". Пятница: "смешной рилс под трендовую музыку".

А теперь положите руку на сердце и скажите: вы реально верите, что вся эта херня приносит вам деньги?

Каждый день вы просыпаетесь с одной мыслью: "Что, блин, сегодня постить?". Вы вымучиваете из себя тексты, от которых тошнит уже на втором абзаце. Снимаете сторис, где с натянутой улыбкой спрашиваете у подписчиков, как им погода. Пляшете в Reels, надеясь, что алгоритм сжалится и подкинет вам пару сотен охватов от ботов и арабов.

Вы не SMM-специалист. Вы — раб на галерах. А ваш контент-план — это унылый ритм барабана, под который вы гребете в никуда.

90% того, что вы называете "ведением соцсетей" — это не маркетинг. Это симуляция бурной деятельности. Имитация работы, чтобы в конце месяца с чистой совестью сказать себе или клиенту: "Ну, я же постил каждый день!".

Да кому какое дело, что ты постил?! Людям плевать на твоё "закулисье", если твой продукт — говно. Им не нужна твоя мотивационная цитата, им нужно решение их проблемы. Ваша лента превратилась в цифровой мусорный бак, забитый однотипным, бездушным контентом, который никто не читает.

Это и есть выгорание. Бессмысленная, монотонная работа, которая не приносит ни радости, ни результата. Полный, тотальный пиздец.

А теперь представьте другую реальность.

Вы не постите месяц. Вообще. Ни одного сторис. Ни одного рилса. А заявки идут. Деньги капают. Клиенты приходят.

Как?

А вот так. Пока вы придумывали "30 идей для постов", я потратил эту неделю на создание системы. Настоящей, мать её, системы, а не очередного контент-плана.

Сайт. Не визитка с вашими фотками, а безжалостная продающая машина. С четким оффером, понятной структурой и одной кнопкой "Купить".

Умная реклама. Не "продвигать пост" за 500 рублей, а настроенный таргет, который бьет точно в целевую аудиторию и ведет её не в ваш профиль с котиками, а прямиком на сайт.

Чат-бот. Робот-продавец, который 24/7 отвечает на тупые вопросы, квалифицирует лидов и дожимает сомневающихся. Пока вы спите.

Вот и всё. Сайт + трафик + автоматизация. Это скучно, да. Тут нет места для "креативных" танцев и "душевных" постов о том, как вы пили латте. Тут есть только цифры, конверсия и результат.

Соцсети в этой системе — не цель, а всего лишь один из источников трафика. Один из многих. Причем самый капризный и геморройный. Он нужен, но он не должен быть центром вашей вселенной.

Хватит грести. Сожгите этот чертов корабль с вашим контент-планом. Перестаньте быть рабом алгоритмов и начните строить систему, которая будет работать на вас, а не вы на неё.

А освободившееся время? Потратьте его на улучшение продукта. Или, в конце концов, просто пойдите и поживите. Говорят, за пределами экрана смартфона есть реальный мир. Но это не точно.

Закупка рекламы у блогеров

16.08.2025 г.

Закупка рекламы у блогеров:

Вы смотрите на этого улыбчивого мальчика или девочку в экране. У него/нее 200 тысяч подписчиков, красивый визуал и, кажется, вся жизнь — сплошной успешный успех. И думаете: "Вот он! Вот тот, кто принесет мне золотые горы!".

Вы переводите ему 50, 100, 300 тысяч рублей. С замиранием сердца ждете дня "Х". И... получаете ничего. Пару сотен лайков от ботов, десяток нецелевых переходов и полное, звенящее ощущение того, что вас только что красиво наебали.

Инфлюенс-маркетинг для 90% предпринимателей — это не маркетинг. Это игра в русскую рулетку. И патроны в этот барабан вы заряжаете собственными руками.

Пуля №1: Вы стреляете с закрытыми глазами.

Видите большую цифру подписчиков и думаете, что это равно успеху. НЕТ. 100 тысяч школьников из Махачкалы не купят ваш B2B-софт. А 500 лояльных, целевых подписчиков у маленького, но зубастого нишевого эксперта — купят. Перестаньте гоняться за цифрами, начните гоняться за релевантностью.

Пуля №2: Вы не проверяете, заряжен ли пистолет.

"Ой, да у него лайкают". Серьезно? Вы собираетесь отдать человеку свои деньги, но вам лень попросить у него два скриншота: статистику по охватам и по демографии аудитории. Если ER (уровень вовлеченности) ниже 2-3%, а в подписчиках — одни арабы и магазины, бегите.

Пуля №3: Вы даете ему пистолет и надеетесь на лучшее.

Ваше ТЗ звучит как "ну, расскажите о нас как-нибудь красиво"? Поздравляю, вы получите именно это — "как-нибудь". Четкое ТЗ — это не "ограничение творчества". Это ваша страховка. Цели, KPI, ключевые сообщения, обязательный призыв к действию, UTM-метка — если этих слов нет в вашем брифе, вы просто дарите деньги.

Пуля №4: Вы заставляете его стрелять левой рукой.

Вы приходите к блогеру, который славится своими смешными скетчами, и даете ему сухое, корпоративное ТЗ. Или заставляете эксперта-зануду плясать в Reels. В итоге ваша реклама звучит, как обращение заложника. Не ломайте формат блогера. Найдите того, чей формат уже подходит вашему продукту. Нативная реклама — это когда ее почти не видно.

Пуля №5: Вы стреляете, но забыли про мишень.

Это просто классика идиотизма. Потратить кучу денег на интеграцию, в которой блогер мило расскажет о вашем продукте и... всё. А что делать-то надо? Куда идти? Что нажать? Если вы не дали аудитории четкий, один-единственный призыв к действию ("перейди по ссылке", "введи промокод"), вы заплатили за то, чтобы вас просто похвалили.

Пуля №6: Вы не знаете, попали ли вы вообще.

"Ну как реклама?" — "Да вроде нормально, подписчики пошли". Это не аналитика, это самовнушение. UTM-метки. Персональные промокоды. Отдельные ссылки. Если вы не можете отследить каждый переход и каждую продажу с конкретной интеграции, считайте, что вы сожгли деньги впустую. Потому что вы ничему не научились и в следующий раз промахнетесь точно так же.

Как не отстрелить себе ногу?

Игра не сфальсифицирована. Вы просто не знаете правил. Инфлюенс-маркетинг — это не магия, это работа. Анализ, проверка, четкое ТЗ, контроль, аналитика.

Перестаньте надеяться на чудо. Начните работать головой. Или наймите того, кто будет делать это за вас. Потому что в этой игре выигрывает не тот, у кого больше денег, а тот, кто меньше ошибается.

Закупка рекламы у блогеров:

Вы смотрите на этого улыбчивого мальчика или девочку в экране. У него/нее 200 тысяч подписчиков, красивый визуал и, кажется, вся жизнь — сплошной успешный успех. И думаете: "Вот он! Вот тот, кто принесет мне золотые горы!".

Вы переводите ему 50, 100, 300 тысяч рублей. С замиранием сердца ждете дня "Х". И... получаете ничего. Пару сотен лайков от ботов, десяток нецелевых переходов и полное, звенящее ощущение того, что вас только что красиво наебали.

Инфлюенс-маркетинг для 90% предпринимателей — это не маркетинг. Это игра в русскую рулетку. И патроны в этот барабан вы заряжаете собственными руками.

Пуля №1: Вы стреляете с закрытыми глазами.

Видите большую цифру подписчиков и думаете, что это равно успеху. НЕТ. 100 тысяч школьников из Махачкалы не купят ваш B2B-софт. А 500 лояльных, целевых подписчиков у маленького, но зубастого нишевого эксперта — купят. Перестаньте гоняться за цифрами, начните гоняться за релевантностью.

Пуля №2: Вы не проверяете, заряжен ли пистолет.

"Ой, да у него лайкают". Серьезно? Вы собираетесь отдать человеку свои деньги, но вам лень попросить у него два скриншота: статистику по охватам и по демографии аудитории. Если ER (уровень вовлеченности) ниже 2-3%, а в подписчиках — одни арабы и магазины, бегите.

Пуля №3: Вы даете ему пистолет и надеетесь на лучшее.

Ваше ТЗ звучит как "ну, расскажите о нас как-нибудь красиво"? Поздравляю, вы получите именно это — "как-нибудь". Четкое ТЗ — это не "ограничение творчества". Это ваша страховка. Цели, KPI, ключевые сообщения, обязательный призыв к действию, UTM-метка — если этих слов нет в вашем брифе, вы просто дарите деньги.

Пуля №4: Вы заставляете его стрелять левой рукой.

Вы приходите к блогеру, который славится своими смешными скетчами, и даете ему сухое, корпоративное ТЗ. Или заставляете эксперта-зануду плясать в Reels. В итоге ваша реклама звучит, как обращение заложника. Не ломайте формат блогера. Найдите того, чей формат уже подходит вашему продукту. Нативная реклама — это когда ее почти не видно.

Пуля №5: Вы стреляете, но забыли про мишень.

Это просто классика идиотизма. Потратить кучу денег на интеграцию, в которой блогер мило расскажет о вашем продукте и... всё. А что делать-то надо? Куда идти? Что нажать? Если вы не дали аудитории четкий, один-единственный призыв к действию ("перейди по ссылке", "введи промокод"), вы заплатили за то, чтобы вас просто похвалили.

Пуля №6: Вы не знаете, попали ли вы вообще.

"Ну как реклама?" — "Да вроде нормально, подписчики пошли". Это не аналитика, это самовнушение. UTM-метки. Персональные промокоды. Отдельные ссылки. Если вы не можете отследить каждый переход и каждую продажу с конкретной интеграции, считайте, что вы сожгли деньги впустую. Потому что вы ничему не научились и в следующий раз промахнетесь точно так же.

Как не отстрелить себе ногу?

Игра не сфальсифицирована. Вы просто не знаете правил. Инфлюенс-маркетинг — это не магия, это работа. Анализ, проверка, четкое ТЗ, контроль, аналитика.

Перестаньте надеяться на чудо. Начните работать головой. Или наймите того, кто будет делать это за вас. Потому что в этой игре выигрывает не тот, у кого больше денег, а тот, кто меньше ошибается.

Экспертиза — это не то, что вы думаете

08.08.2025 г.

Вы открываете соцсети и видите его. "Гуру". Он вещает. Уверенно. Громко. С идеальным светом и из студии, которая стоит как ваша почка. Он смотрит прямо в камеру и с видом пророка, познавшего все тайны вселенной, говорит вам... что вода мокрая, а чтобы зарабатывать, надо работать.

И вы смотрите. И верите. Потому что он говорит это так, будто сам только что изобрёл огонь. Алгоритм экспертизы взломан к чертям.

Раньше работала система "Proof-of-Work" (Доказательство работой). Твой статус определялся твоими кейсами, твоими реальными, осязаемыми результатами.

Сегодня работает система "Proof-of-Talk" (Доказательство разговором). Твой статус определяется не тем, что ты сделал, а тем, как часто и как громко ты об этом говоришь.

Статус "эксперта" сегодня — это не про глубину знаний. Это про громкость крика.

Чем меньше человек знает, тем проще ему быть на 100% уверенным. Он оперирует банальными истинами, которые невозможно оспорить. "Ставьте цели!", "Выходите из зоны комфорта!", "Делегируйте!". А весь его бизнес — это продажа курсов о том, как продавать курсы о том, как быть таким же уверенным в себе пустозвоном.

А где же настоящие профи? Почему их не слышно?

Настоящий хирург не ведет вебинар "5 секретов идеального разреза", он стоит у операционного стола. Настоящий программист не постит 100 сторис о "мышлении кода", он пишет этот код. Настоящий предприниматель не рассказывает, как "поймать дзен", он до 3 ночи сводит баланс, чтобы завтра выплатить зарплату своим сотрудникам.

Настоящая экспертиза молчалива. Не потому что ей нечего сказать. А потому что, во-первых, ей некогда. А во-вторых, чем глубже ты знаешь свой предмет, тем лучше ты понимаешь, как мало ты на самом деле знаешь. Ты понимаешь, что нет простых ответов. И эта сложность, эта глубина не помещается в формат 15-секундного "инсайта" в Reels.

Настоящие профи появляются в инфополе редко. Но когда они это делают, они не кричат очевидные вещи. Они дают детальный разбор одного сложного кейса. Они делятся неудачей и выводами. Они говорят тихо, но каждое их слово весит тонну.

Так что в следующий раз, когда увидите очередного "гуру", который вещает из арендованного "Москва-Сити", просто спросите себя:

Если он такой ахуенный эксперт, откуда у него столько времени на сторис?

Вы открываете соцсети и видите его. "Гуру". Он вещает. Уверенно. Громко. С идеальным светом и из студии, которая стоит как ваша почка. Он смотрит прямо в камеру и с видом пророка, познавшего все тайны вселенной, говорит вам... что вода мокрая, а чтобы зарабатывать, надо работать.

И вы смотрите. И верите. Потому что он говорит это так, будто сам только что изобрёл огонь. Алгоритм экспертизы взломан к чертям.

Раньше работала система "Proof-of-Work" (Доказательство работой). Твой статус определялся твоими кейсами, твоими реальными, осязаемыми результатами.

Сегодня работает система "Proof-of-Talk" (Доказательство разговором). Твой статус определяется не тем, что ты сделал, а тем, как часто и как громко ты об этом говоришь.

Статус "эксперта" сегодня — это не про глубину знаний. Это про громкость крика.

Чем меньше человек знает, тем проще ему быть на 100% уверенным. Он оперирует банальными истинами, которые невозможно оспорить. "Ставьте цели!", "Выходите из зоны комфорта!", "Делегируйте!". А весь его бизнес — это продажа курсов о том, как продавать курсы о том, как быть таким же уверенным в себе пустозвоном.

А где же настоящие профи? Почему их не слышно?

Настоящий хирург не ведет вебинар "5 секретов идеального разреза", он стоит у операционного стола. Настоящий программист не постит 100 сторис о "мышлении кода", он пишет этот код. Настоящий предприниматель не рассказывает, как "поймать дзен", он до 3 ночи сводит баланс, чтобы завтра выплатить зарплату своим сотрудникам.

Настоящая экспертиза молчалива. Не потому что ей нечего сказать. А потому что, во-первых, ей некогда. А во-вторых, чем глубже ты знаешь свой предмет, тем лучше ты понимаешь, как мало ты на самом деле знаешь. Ты понимаешь, что нет простых ответов. И эта сложность, эта глубина не помещается в формат 15-секундного "инсайта" в Reels.

Настоящие профи появляются в инфополе редко. Но когда они это делают, они не кричат очевидные вещи. Они дают детальный разбор одного сложного кейса. Они делятся неудачей и выводами. Они говорят тихо, но каждое их слово весит тонну.

Так что в следующий раз, когда увидите очередного "гуру", который вещает из арендованного "Москва-Сити", просто спросите себя:

Если он такой ахуенный эксперт, откуда у него столько времени на сторис?

БОЙСЯ НЕ НЕЙРОСЕТЬ. БОЙСЯ МЕНЯ

25.07.2025 г.

Нейросеть не отнимет вашу работу. Её отниму я.

Каждый день я читаю один и тот же вой в профессиональных чатиках и комментариях. "О боже, ИИ заменит копирайтеров!", "Дизайнеры больше не нужны!", "Маркетологи, нам всем конец!".

Вы серьезно?

Вы смотрите на молоток и боитесь, что он сам построит дом и выставит вас на улицу. Вы смотрите на экскаватор и плачете, что он отнял работу у землекопа с лопатой. Вы сидите в своей уютной пещерке, боитесь огня и даже не представляете, что им можно не только обжечься, но и приготовить ахуенный стейк.

Давайте начистоту. Нейросеть не отнимет вашу работу.

Её отниму я. И такие, как я.

Люди, которые не потратили ни секунды на страх. Люди, которые вместо того, чтобы ныть о "восстании машин", открыли ноутбук и начали эти машины приручать.

Пока вы вчера обсуждали этические дилеммы ChatGPT, я с его помощью:

Набросал контент-план на месяц для клиента, который раньше высасывал из меня все соки неделями.

Написал 5 SEO-оптимизированных статей для блога, которые уже сегодня начнут приносить органический трафик.

Сгенерировал 20 уникальных визуалов в Midjourney для рекламной кампании, пока ваш дизайнер третий день двигал пиксели в "идеальной" композиции.

Проанализировав боли целевой аудитории по отзывам с десятка сайтов. На это ушло 15 минут. Пятнадцать. Минут.

Я не стал умнее вас. Я не получил секретного знания от иллюминатов. Я просто не стал ждать, пока мир изменится. Я взял новый инструмент и начал им херачить.

ИИ — это не ваш конкурент. Это ваш мультипликатор силы. Это самый мощный допинг для мозга, который когда-либо существовал. Он не заменяет мозги, он их усиливает. Если, конечно, они у вас есть.

Если вся ваша "экспертиза" заключалась в умении переписывать чужие тексты, подбирать синонимы и компилировать информацию из первых трех ссылок в Google — да, вам пиздец. Полный и окончательный. Но давайте будем честными: вас бы рано или поздно заменил любой толковый студент-первокурсник. Нейросеть просто ускорила этот неизбежный процесс.

Но если вы — стратег, креатор, человек, который умеет ставить задачи, видеть картину в целом и генерировать идеи, то ИИ — это ваш личный батальон. Батальон неутомимых, бесплатных стажеров, которые готовы работать 24/7 без нытья и перекуров.

Так что перестаньте бояться нейросеть. Это глупо и контрпродуктивно.

Бойтесь людей, которые уже сейчас делают вашу месячную норму за один вечер, посмеиваясь над вашими страхами.

Бойтесь тех, кто предлагает клиентам не "посты по контент-плану", а комплексные решения, реализованные с помощью ИИ в десять раз быстрее и дешевле.

Бойтесь тех, кто, пока вы боитесь, учится.

Или... не бойтесь. А просто откройте ноутбук и начните учиться сами. Прямо сейчас. Потому что завтра может быть уже поздно. Завтра вашу работу предложат мне. И я соглашусь.

А вы можете и дальше обсуждать, этично ли это.

Нейросеть не отнимет вашу работу. Её отниму я.

Каждый день я читаю один и тот же вой в профессиональных чатиках и комментариях. "О боже, ИИ заменит копирайтеров!", "Дизайнеры больше не нужны!", "Маркетологи, нам всем конец!".

Вы серьезно?

Вы смотрите на молоток и боитесь, что он сам построит дом и выставит вас на улицу. Вы смотрите на экскаватор и плачете, что он отнял работу у землекопа с лопатой. Вы сидите в своей уютной пещерке, боитесь огня и даже не представляете, что им можно не только обжечься, но и приготовить ахуенный стейк.

Давайте начистоту. Нейросеть не отнимет вашу работу.

Её отниму я. И такие, как я.

Люди, которые не потратили ни секунды на страх. Люди, которые вместо того, чтобы ныть о "восстании машин", открыли ноутбук и начали эти машины приручать.

Пока вы вчера обсуждали этические дилеммы ChatGPT, я с его помощью:

Набросал контент-план на месяц для клиента, который раньше высасывал из меня все соки неделями.

Написал 5 SEO-оптимизированных статей для блога, которые уже сегодня начнут приносить органический трафик.

Сгенерировал 20 уникальных визуалов в Midjourney для рекламной кампании, пока ваш дизайнер третий день двигал пиксели в "идеальной" композиции.

Проанализировав боли целевой аудитории по отзывам с десятка сайтов. На это ушло 15 минут. Пятнадцать. Минут.

Я не стал умнее вас. Я не получил секретного знания от иллюминатов. Я просто не стал ждать, пока мир изменится. Я взял новый инструмент и начал им херачить.

ИИ — это не ваш конкурент. Это ваш мультипликатор силы. Это самый мощный допинг для мозга, который когда-либо существовал. Он не заменяет мозги, он их усиливает. Если, конечно, они у вас есть.

Если вся ваша "экспертиза" заключалась в умении переписывать чужие тексты, подбирать синонимы и компилировать информацию из первых трех ссылок в Google — да, вам пиздец. Полный и окончательный. Но давайте будем честными: вас бы рано или поздно заменил любой толковый студент-первокурсник. Нейросеть просто ускорила этот неизбежный процесс.

Но если вы — стратег, креатор, человек, который умеет ставить задачи, видеть картину в целом и генерировать идеи, то ИИ — это ваш личный батальон. Батальон неутомимых, бесплатных стажеров, которые готовы работать 24/7 без нытья и перекуров.

Так что перестаньте бояться нейросеть. Это глупо и контрпродуктивно.

Бойтесь людей, которые уже сейчас делают вашу месячную норму за один вечер, посмеиваясь над вашими страхами.

Бойтесь тех, кто предлагает клиентам не "посты по контент-плану", а комплексные решения, реализованные с помощью ИИ в десять раз быстрее и дешевле.

Бойтесь тех, кто, пока вы боитесь, учится.

Или... не бойтесь. А просто откройте ноутбук и начните учиться сами. Прямо сейчас. Потому что завтра может быть уже поздно. Завтра вашу работу предложат мне. И я соглашусь.

А вы можете и дальше обсуждать, этично ли это.

Мои Инструкции (Аптечка для маркетолога и сочувствующих)

21.07.2025 г.

Так, банда. Открыл сегодня папку «Сохраненное» и чуть не ослеп от количества моих же постов. Похоже на цифровое кладбище гениальных идей, до которых у вас никогда не дойдут руки. Знакомо?

Каждый второй в директе ноет: «Рома, хочу в нейросети, но ничего не понятно», «Рома, как делать такие картинки?», «Рома, спаси, дедлайн горит, а я туплю над презентацией».

Цифровые пинки под зад, чтобы вы перестали бояться и начали, наконец, использовать ИИ как свой личный батальон рабов.

Мои Инструкции (Аптечка для маркетолога и сочувствующих):

1. ИИ-ДВОЙНИК: ОБУЧИ НЕЙРОСЕТЬ ПИСАТЬ КАК ТЫ

По этой инструкции ты натаскаешь нейронку копировать твой стиль, юмор, сарказм — да хоть манеру речи твоей бывшей. Чтобы никто не догадался, что пост за тебя писал кремниевый друг.

2. АРТ-ДИРЕКТОР В КАРМАНЕ: ГЕНЕРАЦИЯ КАРТИНОК + 10 ИИ В ПОДАРОК

Смотрю на ваши промпты «красивая девушка на закате» и хочу плакать. Я научу вас писать запросы, от которых нейросеть выдаст вам не кашу, а шедевр. Плюс накину сверху 10 площадок, где можно творить эту магию (большинство — бесплатно). Хватит постить убогие фотки со стоков.

3. AI-ПРИМЕРОЧНАЯ: ТВОЙ ШМОТ НА КОМ УГОДНО

Для тех, кто в фэшн-бизнесе или просто хочет перестать гадать, как эта кофта сядет на реальном человеке. Загрузил фотку шмотки, фотку модели (хоть свою) — получил готовый лукбук. Технология, за которую бренды отвалят миллионы, у тебя на компе.

4. ПРЕЗЕНТАЦИЯ ЗА 5 МИНУТ, ПОКА ЗАВАРИВАЕТСЯ КОФЕ

Ненавидишь PowerPoint? Я тоже. Поэтому вот гайд, как заставить ИИ сделать всю грязную работу за тебя. Структура, дизайн, текст — всё будет готово, пока ты ищешь чистую кружку. Перестань позориться слайдами из 2007-го.

5. ТВОЙ ЛИЧНЫЙ ИИ-РАБ В TELEGRAM

Создай себе чат-бота, который будет подключен к твоему мозгу (точнее, к твоим базам знаний) и отвечать на вопросы за тебя. Для клиентов, для сотрудников, для самого себя, когда лень искать инфу.

6. НЕЙРО-КОПИРАЙТЕР: ОТ БОЛВАНКИ ДО МАШИНЫ ДЛЯ ТЕКСТОВ

Это не про «скопировать стиль» (см. пункт 1). Это про то, как из тупой нейронки сделать профессионального копирайтера, который умеет в ЦА, боли, триггеры и продающие структуры. Для тех, кто хочет не просто посты, а тексты, которые приносят деньги.

7. АНИМАЦИЯ ДЛЯ ЛЕНИВЫХ: ОЖИВИ ЛЮБУЮ КАРТИНКУ

Статичные изображения — прошлый век. В этом гайде я на пальцах (и скриншотах) показываю, как заставить любую картинку или арт двигаться. Никаких знаний в After Effects. Просто пара кликов — и ваш визуал уделает 90% конкурентов. Бонусом — еще 5 нейронок для экспериментов.

8. CHATGPT: ИНСТРУКЦИЯ ПО ПРИМЕНЕНИЮ МОЗГА

Хватит использовать ChatGPT как Google для бедных. Я вскрыл его вдоль и поперек и показываю, как писать промпты, которые дают результат, а не воду. Все фишки, режимы, лайфхаки и объяснение, когда стоит платить, а когда нет. Это база. Это должен знать каждый.

🔥 СПЕЦПРЕДЛОЖЕНИЯ ДЛЯ РЕШИТЕЛЬНЫХ 🔥

9. БОЛЬШОЙ КУРС «ТЕКСТОВЫЕ НЕЙРОСЕТИ С НУЛЯ»

Если ты понимаешь, что точечные гайды — это круто, но хочешь нырнуть в эту кроличью нору с головой и выйти оттуда профессионалом. Это полная система. От «что такое нейросеть» до автоматизации всей текстовой рутины. Для тех, кто хочет не просто пользоваться, а доминировать.

Подробности тут: https://smmrrr.ru/coursetext

10.👑 КОМБО «ХОЧУ ВСЁ!» (ALL-INCLUSIVE ДЛЯ УМНЫХ)

Для тех, кто не любит выбирать. Получаешь доступ ко ВСЕМ вышеперечисленным инструкциям (кроме большого курса). И ко всем будущим, которые я выпущу. Навсегда. Один раз платишь — и получаешь вечную подписку на мой мозг и все мои наработки. Это не покупка, это инвестиция.

КАК КУПИТЬ?

Всё просто. Переходи в бота https://t.me/ayakakskazalbot и выбирай. Следующая инструкция будет по Midjourney

Так, банда. Открыл сегодня папку «Сохраненное» и чуть не ослеп от количества моих же постов. Похоже на цифровое кладбище гениальных идей, до которых у вас никогда не дойдут руки. Знакомо?

Каждый второй в директе ноет: «Рома, хочу в нейросети, но ничего не понятно», «Рома, как делать такие картинки?», «Рома, спаси, дедлайн горит, а я туплю над презентацией».

Цифровые пинки под зад, чтобы вы перестали бояться и начали, наконец, использовать ИИ как свой личный батальон рабов.

Мои Инструкции (Аптечка для маркетолога и сочувствующих):

1. ИИ-ДВОЙНИК: ОБУЧИ НЕЙРОСЕТЬ ПИСАТЬ КАК ТЫ

По этой инструкции ты натаскаешь нейронку копировать твой стиль, юмор, сарказм — да хоть манеру речи твоей бывшей. Чтобы никто не догадался, что пост за тебя писал кремниевый друг.

2. АРТ-ДИРЕКТОР В КАРМАНЕ: ГЕНЕРАЦИЯ КАРТИНОК + 10 ИИ В ПОДАРОК

Смотрю на ваши промпты «красивая девушка на закате» и хочу плакать. Я научу вас писать запросы, от которых нейросеть выдаст вам не кашу, а шедевр. Плюс накину сверху 10 площадок, где можно творить эту магию (большинство — бесплатно). Хватит постить убогие фотки со стоков.

3. AI-ПРИМЕРОЧНАЯ: ТВОЙ ШМОТ НА КОМ УГОДНО

Для тех, кто в фэшн-бизнесе или просто хочет перестать гадать, как эта кофта сядет на реальном человеке. Загрузил фотку шмотки, фотку модели (хоть свою) — получил готовый лукбук. Технология, за которую бренды отвалят миллионы, у тебя на компе.

4. ПРЕЗЕНТАЦИЯ ЗА 5 МИНУТ, ПОКА ЗАВАРИВАЕТСЯ КОФЕ

Ненавидишь PowerPoint? Я тоже. Поэтому вот гайд, как заставить ИИ сделать всю грязную работу за тебя. Структура, дизайн, текст — всё будет готово, пока ты ищешь чистую кружку. Перестань позориться слайдами из 2007-го.

5. ТВОЙ ЛИЧНЫЙ ИИ-РАБ В TELEGRAM

Создай себе чат-бота, который будет подключен к твоему мозгу (точнее, к твоим базам знаний) и отвечать на вопросы за тебя. Для клиентов, для сотрудников, для самого себя, когда лень искать инфу.

6. НЕЙРО-КОПИРАЙТЕР: ОТ БОЛВАНКИ ДО МАШИНЫ ДЛЯ ТЕКСТОВ

Это не про «скопировать стиль» (см. пункт 1). Это про то, как из тупой нейронки сделать профессионального копирайтера, который умеет в ЦА, боли, триггеры и продающие структуры. Для тех, кто хочет не просто посты, а тексты, которые приносят деньги.

7. АНИМАЦИЯ ДЛЯ ЛЕНИВЫХ: ОЖИВИ ЛЮБУЮ КАРТИНКУ

Статичные изображения — прошлый век. В этом гайде я на пальцах (и скриншотах) показываю, как заставить любую картинку или арт двигаться. Никаких знаний в After Effects. Просто пара кликов — и ваш визуал уделает 90% конкурентов. Бонусом — еще 5 нейронок для экспериментов.

8. CHATGPT: ИНСТРУКЦИЯ ПО ПРИМЕНЕНИЮ МОЗГА

Хватит использовать ChatGPT как Google для бедных. Я вскрыл его вдоль и поперек и показываю, как писать промпты, которые дают результат, а не воду. Все фишки, режимы, лайфхаки и объяснение, когда стоит платить, а когда нет. Это база. Это должен знать каждый.

🔥 СПЕЦПРЕДЛОЖЕНИЯ ДЛЯ РЕШИТЕЛЬНЫХ 🔥

9. БОЛЬШОЙ КУРС «ТЕКСТОВЫЕ НЕЙРОСЕТИ С НУЛЯ»

Если ты понимаешь, что точечные гайды — это круто, но хочешь нырнуть в эту кроличью нору с головой и выйти оттуда профессионалом. Это полная система. От «что такое нейросеть» до автоматизации всей текстовой рутины. Для тех, кто хочет не просто пользоваться, а доминировать.

Подробности тут: https://smmrrr.ru/coursetext

10.👑 КОМБО «ХОЧУ ВСЁ!» (ALL-INCLUSIVE ДЛЯ УМНЫХ)

Для тех, кто не любит выбирать. Получаешь доступ ко ВСЕМ вышеперечисленным инструкциям (кроме большого курса). И ко всем будущим, которые я выпущу. Навсегда. Один раз платишь — и получаешь вечную подписку на мой мозг и все мои наработки. Это не покупка, это инвестиция.

КАК КУПИТЬ?

Всё просто. Переходи в бота https://t.me/ayakakskazalbot и выбирай. Следующая инструкция будет по Midjourney

8 AI-инструментов, которые стоит попробовать бизнесу в 2025 году

20.06.2025 г.

Не бойтесь ИИ, используйте его

Я полагаю, что большинство из нас в какой-то момент задумывались о сценарии, в котором ИИ повлияет на нашу карьеру, особенно в последние пару лет. И хотя это звучит пугающе и не совсем неправдоподобно, я думаю, что цитата со-основателя Netflix Теда Сарандоса довольно хорошо подводит итог будущему: «ИИ не отнимет вашу работу, но человек, который хорошо использует ИИ, вполне может это сделать».

Так что вместо того, чтобы бояться и задаваться вопросом, что может произойти дальше, будьте в курсе событий и извлекайте пользу из ИИ. Существует множество удивительных ИИ-инструментов, которые могут быстро автоматизировать трудоемкие задачи или подстегнуть ваше творчество, когда вам это нужно.

Я поделюсь топ-8 ИИ-инструментов, которые вы можете использовать для своего бизнеса уже сегодня:

1. Presentations.ai: Создание презентаций

Не знаю, как вы, ребята, но для меня создание презентаций — довольно утомительная задача. Хотя это и не слишком сложно и не требует особых технических навыков, я все равно трачу часы на поиск подходящего шаблона для слайдов, обобщение информации, настройку макетов и все такое прочее. Но теперь я могу сэкономить драгоценное время благодаря таким инструментам, как Presentations.ai, который вы можете попробовать бесплатно.

Вот как это работает: вы вводите свою тему, затем выбираете язык и количество слайдов. После этого предоставляете информацию, которую хотите включить, через PDF-файл или по ссылке (URL), и нажимаете «Отправить». Прежде чем подготовить полную презентацию, он представит вам содержание каждого слайда, по сути, как план, чтобы вы могли заранее все скорректировать. Как только вы будете довольны результатом, просто нажмите кнопку, и вуаля — ваши слайды готовы.

Вы все еще можете редактировать их по своему усмотрению и выбирать различные шаблоны и темы. Можете представить, сколько времени это мне сэкономило? Более чем достаточно, чтобы убедить вас попробовать самим.

2. Coral AI: Ваш собеседник для PDF-документов

Продолжая тему инструментов, экономящих время, у нас есть Coral AI. По сути, вам просто нужно загрузить любой PDF-файл, на чтение которого у вас нет времени, и как только ИИ-инструмент его обработает, вы сможете вести с ним диалог о содержании вашего документа. Это может сэкономить вам массу времени, поскольку он обобщает и представляет нужную информацию за секунды, на поиск которой вы могли бы потратить часы. Вы получаете не только ответы, но и номера страниц, откуда они были взяты, так что вы знаете, где найти точные цитаты. Это может быть чрезвычайно полезно для профессиональных исследователей, студентов и просто любого, у кого есть PDF для чтения.

3. Hostinger Website Builder: Создайте сайт за минуту

Третий инструмент в моем списке — это конструктор сайтов от Hostinger. Конструктор сайтов от Hostinger, работающий на базе ИИ, может создать для вас веб-сайт буквально менее чем за минуту. Можете засечь время. Вам просто нужно ввести описание вашего бизнеса и выбрать тип сайта. Вот и все. Никакого кодинга, никаких веб-дизайнеров. ИИ делает самую сложную часть работы за вас.

Я бы сказал, что это идеальный вариант для начинающих предпринимателей, которые хотят сэкономить время, не тратя при этом слишком много денег. Плюс, им быстро пользоваться благодаря редактору с функцией перетаскивания (drag-and-drop). Более того, когда вы переходите к редактированию сайта, вы можете использовать множество встроенных ИИ-инструментов для создания контента. Например, есть ИИ-писатель, если вам нужно быстро сгенерировать текст или ускорить процесс написания для вашего блога.

Также с конструктором сайтов поставляется множество удобных ИИ-инструментов для электронной коммерции:

4. Zapier: Автоматизация рутинных задач

Следующий инструмент, который я настоятельно рекомендую вам попробовать, — это Zapier. Это приложение работает как менеджер рабочих процессов и экономит ваше время, автоматизируя монотонные задачи в разных приложениях, чтобы вам не приходилось делать их вручную. Например, если кто-то покупает ваш цифровой продукт через PayPal, Zapier может автоматически добавить его email в MailChimp или другой список рассылки и отправить ему приветственное письмо.

Вы можете найти множество полезных шаблонов для этих рабочих процессов или "zaps", как их называют. Вы также можете создать свой собственный, полностью основанный на ваших потребностях. Вы просто выбираете приложение, учетную запись и событие, за которым должен следить Zapier, например, Google Sheets, затем выбираете документ и добавляете определенный столбец. Добавьте еще один шаг таким же образом и выберите, какие действия вы хотите, чтобы Zapier предпринял. Вот и все.

5. Adobe Firefly: Бесплатный генератор изображений и графики

Это бесплатный ИИ-инструмент для творчества, который генерирует потрясающую графику и изображения, а скоро вы даже сможете генерировать с его помощью видео. Вы, вероятно, знаете, что существует довольно много ИИ-генераторов изображений, но не все из них хороши и не все из них бесплатны.

Так что я бы сказал, что Firefly — довольно хороший вариант, особенно если вы новичок во всем этом ИИ-деле. Он работает путем простого ввода текстовой подсказки, описывающей то, что вы хотите, и Firefly использует свою ИИ-магию для создания визуальных эффектов, соответствующих вашему описанию.

6. Twain.ai: Ваш личный редактор текстов

Этот ИИ призван улучшить ваши навыки письма, гарантируя, что все, что вы пишете, будет ясным, профессиональным и донесет вашу мысль. Он помогает исправлять грамматические ошибки, правильно подбирать тон и даже дает предложения по структурированию предложений. Что приятно, Twain позволяет вам выбирать канал, который вы хотите использовать, а также ваше намерение, тон и вариант использования, чтобы текст идеально соответствовал вашим потребностям. Не ждите, что он напишет ваш следующий роман или превратит вас во Франца Кафку за одну ночь, но для повседневных задач, таких как электронные письма, отчеты и презентации, Twain AI справится с этим.

7. Ocean.io: Поиск идеальных B2B-клиентов

Просто добавьте URL-адрес одного из клиентов и подождите, пока ИИ подготовит огромный список похожих компаний. Это очень удобно, потому что он также добавляет их контактную информацию, страну, размер — все в одном месте. В общем, Ocean.io действительно может помочь вам оптимизировать процесс продаж и сэкономить драгоценное время, чтобы вы могли больше сосредоточиться на развитии своего бизнеса.

8. Autopod: Автоматический видеомонтаж для подкастеров

Я очень хотел включить его, потому что знаю, что среди вас определенно есть создатели контента, так что это для вас, особенно если вы подкастер. Autopod — это ИИ-инструмент, разработанный для упрощения редактирования видео. Он автоматически переключается между различными ракурсами камеры в зависимости от того, кто говорит, синхронизирует ваше аудио и видео и даже помогает с такими вещами, как обрезка ошибок или неловких пауз. Я имею в виду, если вы когда-либо редактировали что-то подобное, вы знаете, насколько трудоемким может быть редактирование. Так что вместо того, чтобы часами редактировать эти вещи вручную, Autopod позволяет вам больше сосредоточиться на создании отличного контента, в то время как он берет на себя технические хлопоты.

Не бойтесь ИИ, используйте его

Я полагаю, что большинство из нас в какой-то момент задумывались о сценарии, в котором ИИ повлияет на нашу карьеру, особенно в последние пару лет. И хотя это звучит пугающе и не совсем неправдоподобно, я думаю, что цитата со-основателя Netflix Теда Сарандоса довольно хорошо подводит итог будущему: «ИИ не отнимет вашу работу, но человек, который хорошо использует ИИ, вполне может это сделать».

Так что вместо того, чтобы бояться и задаваться вопросом, что может произойти дальше, будьте в курсе событий и извлекайте пользу из ИИ. Существует множество удивительных ИИ-инструментов, которые могут быстро автоматизировать трудоемкие задачи или подстегнуть ваше творчество, когда вам это нужно.

Я поделюсь топ-8 ИИ-инструментов, которые вы можете использовать для своего бизнеса уже сегодня:

1. Presentations.ai: Создание презентаций

Не знаю, как вы, ребята, но для меня создание презентаций — довольно утомительная задача. Хотя это и не слишком сложно и не требует особых технических навыков, я все равно трачу часы на поиск подходящего шаблона для слайдов, обобщение информации, настройку макетов и все такое прочее. Но теперь я могу сэкономить драгоценное время благодаря таким инструментам, как Presentations.ai, который вы можете попробовать бесплатно.

Вот как это работает: вы вводите свою тему, затем выбираете язык и количество слайдов. После этого предоставляете информацию, которую хотите включить, через PDF-файл или по ссылке (URL), и нажимаете «Отправить». Прежде чем подготовить полную презентацию, он представит вам содержание каждого слайда, по сути, как план, чтобы вы могли заранее все скорректировать. Как только вы будете довольны результатом, просто нажмите кнопку, и вуаля — ваши слайды готовы.

Вы все еще можете редактировать их по своему усмотрению и выбирать различные шаблоны и темы. Можете представить, сколько времени это мне сэкономило? Более чем достаточно, чтобы убедить вас попробовать самим.

2. Coral AI: Ваш собеседник для PDF-документов

Продолжая тему инструментов, экономящих время, у нас есть Coral AI. По сути, вам просто нужно загрузить любой PDF-файл, на чтение которого у вас нет времени, и как только ИИ-инструмент его обработает, вы сможете вести с ним диалог о содержании вашего документа. Это может сэкономить вам массу времени, поскольку он обобщает и представляет нужную информацию за секунды, на поиск которой вы могли бы потратить часы. Вы получаете не только ответы, но и номера страниц, откуда они были взяты, так что вы знаете, где найти точные цитаты. Это может быть чрезвычайно полезно для профессиональных исследователей, студентов и просто любого, у кого есть PDF для чтения.

3. Hostinger Website Builder: Создайте сайт за минуту

Третий инструмент в моем списке — это конструктор сайтов от Hostinger. Конструктор сайтов от Hostinger, работающий на базе ИИ, может создать для вас веб-сайт буквально менее чем за минуту. Можете засечь время. Вам просто нужно ввести описание вашего бизнеса и выбрать тип сайта. Вот и все. Никакого кодинга, никаких веб-дизайнеров. ИИ делает самую сложную часть работы за вас.

Я бы сказал, что это идеальный вариант для начинающих предпринимателей, которые хотят сэкономить время, не тратя при этом слишком много денег. Плюс, им быстро пользоваться благодаря редактору с функцией перетаскивания (drag-and-drop). Более того, когда вы переходите к редактированию сайта, вы можете использовать множество встроенных ИИ-инструментов для создания контента. Например, есть ИИ-писатель, если вам нужно быстро сгенерировать текст или ускорить процесс написания для вашего блога.

Также с конструктором сайтов поставляется множество удобных ИИ-инструментов для электронной коммерции:

- Создание товаров с помощью ИИ: загрузите фотографию вашего продукта, ИИ сгенерирует для вас название, описание и цену. Вы даже можете делать это массово, до 10 фотографий за раз, что позволяет мгновенно создавать несколько товаров.

- Удаление фона с помощью ИИ: как только у вас появятся описания, нужно подумать и о фотографиях. ИИ для удаления фона поможет вам сделать лучшее изображение продукта, стерев фон всего за несколько секунд.